卡卡字幕助手

VideoCaptioner

一款基于大语言模型(LLM)的视频字幕处理助手,支持语音识别、字幕断句、优化、翻译全流程处理

简体中文 / [English](./docs/README_EN.md)

## 📖 项目介绍

卡卡字幕助手(VideoCaptioner)操作简单且无需高配置,支持网络调用和本地离线(支持调用GPU)两种方式进行语音识别,利用可用通过大语言模型进行字幕智能断句、校正、翻译,字幕视频全流程一键处理!为视频配上效果惊艳的字幕。

- 🎯 无需GPU即可使用强大的语音识别引擎,生成精准字幕

- ✂️ 基于 LLM 的智能分割与断句,字幕阅读更自然流畅

- 🔄 AI字幕多线程优化与翻译,调整字幕格式、表达更地道专业

- 🎬 支持批量视频字幕合成,提升处理效率

- 📝 直观的字幕编辑查看界面,支持实时预览和快捷编辑

- 🤖 消耗模型 Token 少,且内置基础 LLM 模型,保证开箱即用

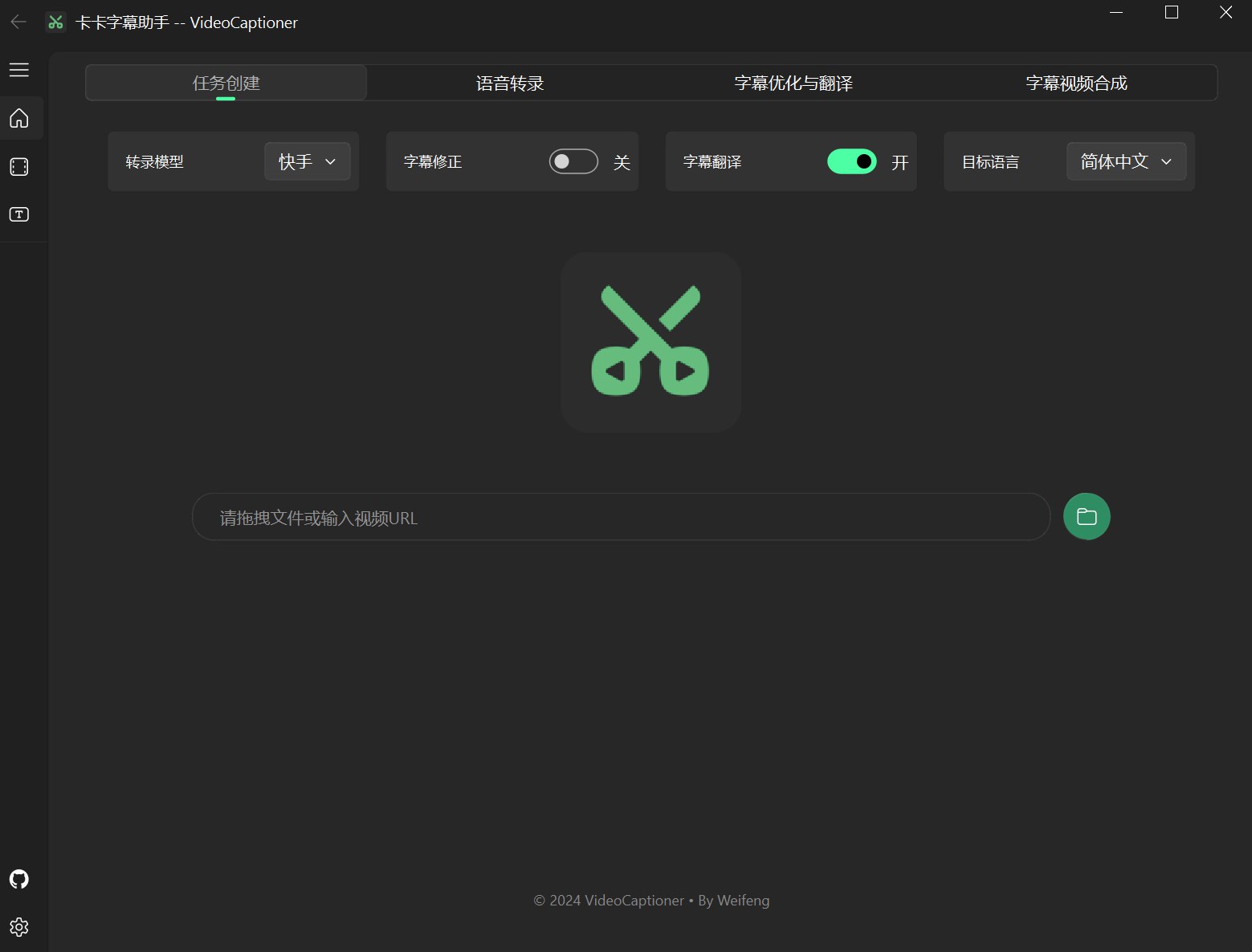

## 📸 界面预览